Peter Holmes

0

5554

183

Sztuczna inteligencja i uczenie maszynowe przyczyniają się do wielu postępów, jakie widzimy dzisiaj w branży technologicznej. Ale w jaki sposób maszyny mają zdolność uczenia się? Ponadto, w jaki sposób sposób, w jaki to robimy, powoduje niezamierzone konsekwencje?

Oto nasz szybki objaśnienie działania algorytmów uczenia maszynowego wraz z kilkoma przykładami uczenia maszynowego, które poszły nie tak.

Jakie są algorytmy uczenia maszynowego?

Uczenie maszynowe to dziedzina informatyki, która koncentruje się na zapewnieniu sztucznej inteligencji możliwości uczenia się 5 najlepszych eksperymentów AI w Google do eksploracji sztucznej inteligencji 5 najlepszych eksperymentów Google w AI do eksploracji sztucznej inteligencji Google ma kilka eksperymentów AI, z którymi możesz grać, prawda teraz. Dzięki uczeniu maszynowemu mogą one zmienić świat jutra z Twoją pomocą. . Obejmuje to rozwijanie umiejętności bez wyraźnego kodowania sztucznej inteligencji przez programistów, aby wykonywać te czynności. Zamiast tego AI może wykorzystywać dane do uczenia się.

Programiści osiągają to dzięki algorytmom uczenia maszynowego. Algorytmy te są modelami, na których opiera się zachowanie uczenia się AI. Algorytmy w połączeniu ze szkoleniowymi zestawami danych umożliwiają AI naukę.

Algorytm zwykle zapewnia model, za pomocą którego AI może rozwiązać problem. Na przykład nauczenie się rozpoznawania zdjęć kotów i psów. AI stosuje model określony przez algorytm do zbioru danych, który zawiera obrazy kotów i psów. Z czasem sztuczna inteligencja nauczy się, jak identyfikować koty z psów w sposób dokładniejszy i łatwiejszy, bez udziału człowieka.

Uczenie maszynowe usprawnia technologie, takie jak wyszukiwarki, urządzenia inteligentnego domu, usługi online i maszyny autonomiczne. W ten sposób Netflix wie, które filmy bardziej Ci się podobają i w jaki sposób serwisy do przesyłania muzyki mogą polecać listy odtwarzania.

Ale chociaż uczenie maszynowe może znacznie ułatwić nam życie, mogą mieć również nieoczekiwane konsekwencje.

7 razy, gdy uczenie maszynowe poszło nie tak

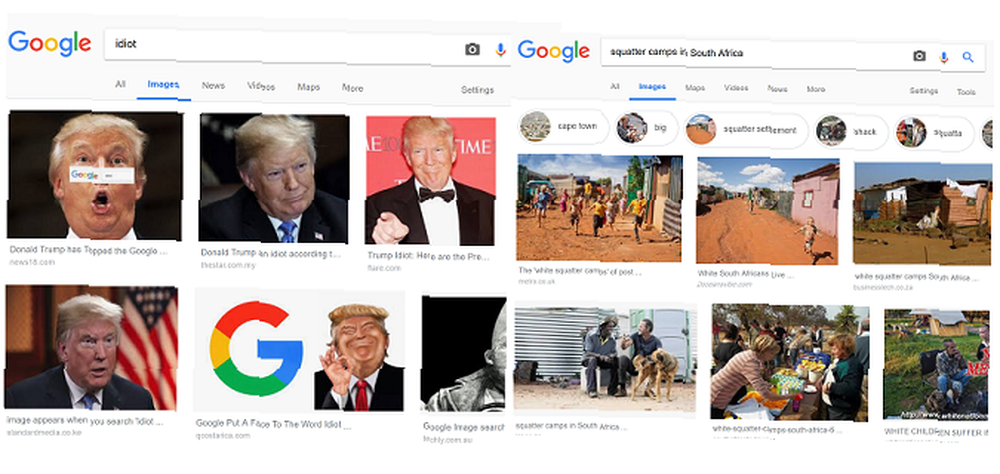

1. Nieudane wyniki wyszukiwania grafiki Google

Wyszukiwarka Google znacznie ułatwiła poruszanie się po Internecie. Algorytm silnika bierze pod uwagę różne rzeczy podczas generowania wyników, takie jak słowa kluczowe i współczynnik odrzuceń. Ale algorytm uczy się również z ruchu użytkowników, co może powodować problemy z jakością wyników wyszukiwania.

Nigdzie nie jest to bardziej widoczne niż w obrazach. Ponieważ strony o dużym natężeniu ruchu częściej wyświetlają swoje obrazy, historie, które przyciągają dużą liczbę użytkowników, w tym przynęty na kliknięcia, są często traktowane priorytetowo.

Na przykład wyniki wyszukiwania obrazu dla “squatters obozów w Afryce Południowej” wywołało kontrowersje, gdy odkryto, że w przeważającej części byli to biali południowoafrykańscy. Dzieje się tak pomimo statystyk wskazujących, że przeważająca większość osób mieszkających w nieformalnych domach, takich jak szałasy, to czarni mieszkańcy Afryki Południowej.

Czynniki zastosowane w algorytmie Google oznaczają również, że internauci mogą manipulować wynikami. Na przykład kampania przeprowadzona przez użytkowników wpłynęła na wyniki wyszukiwania grafiki Google w takim zakresie, w jakim szukają tego terminu “idiota” pokazuje zdjęcia prezydenta USA Donalda Trumpa.

2. Microsoft Bot zamienił się w nazistę

Zaufaj Twitterowi, aby zniszczyć dobrze działającego chatbota uczącego się na maszynie. Tak stało się w ciągu dnia od wydania znanego teraz Microsoft chatbota Tay.

Tay naśladowała wzorce językowe nastoletniej dziewczyny i uczyła się dzięki jej interakcjom z innymi użytkownikami Twittera. Stała się jednak jednym z najbardziej niesławnych błędów AI, kiedy zaczęła dzielić się nazistowskimi oświadczeniami i obelgami rasowymi. Okazuje się, że trolle wykorzystały maszynową sztuczną inteligencję do uczenia się przeciwko niej, zalewając ją interakcjami wypełnionymi bigoterią.

Niedługo potem Microsoft na dobre przełączył Tay'a w tryb offline.

3. Problemy z rozpoznawaniem twarzy AI

Rozpoznawanie twarzy AI często pojawia się w nagłówkach ze wszystkich niewłaściwych powodów, takich jak historie o rozpoznawaniu twarzy i obawach dotyczących prywatności. Ale ta sztuczna inteligencja spowodowała również poważne obawy podczas próby rozpoznania ludzi w kolorze.

W 2015 r. Użytkownicy odkryli, że Zdjęcia Google klasyfikują niektórych czarnych ludzi jako goryle. W 2018 r. Badania przeprowadzone przez ACLU wykazały, że oprogramowanie do identyfikacji twarzy Rekognition firmy Amazon zidentyfikowało 28 członków Kongresu USA jako podejrzanych o policję, a fałszywie pozytywne wyniki w nieproporcjonalny sposób wpływają na osoby kolorowe.

Kolejny incydent dotyczył oprogramowania Apple Face ID Kupujesz iPhone'a X? Identyfikator twarzy może sprawić, że zastanowisz się nad zakupem iPhone'a X? Face ID może sprawić, że ponownie się zastanowisz Najważniejszą funkcją iPhone'a X jest system odblokowywania urządzenia Face ID. Ale jak bezpieczne? Czy Apple będzie miał dostęp do ogromnej bazy twarzy wszystkich osób? błędnie identyfikuje dwie różne Chinki jako tę samą osobę. W rezultacie kolega właściciela iPhone'a X mógł odblokować telefon.

Tymczasem Joy Buolamwini, badacz z MIT, przypomina, że często musi nosić białą maskę podczas pracy nad technologią rozpoznawania twarzy, aby oprogramowanie ją rozpoznało. Aby rozwiązać takie problemy, Buolamwini i inni specjaliści IT zwracają uwagę na problem i potrzebę bardziej kompletnych zestawów danych do szkolenia AI.

4. Deepfakes używane do mistyfikacji

Podczas gdy ludzie od dawna używają Photoshopa do tworzenia fałszywych obrazów, uczenie maszynowe przenosi to na nowy poziom. Oprogramowanie takie jak FaceApp pozwala zamieniać obiekty z jednego filmu na drugi.

Ale wiele osób wykorzystuje oprogramowanie do różnych złośliwych zastosowań, w tym nakładania twarzy gwiazd na filmy dla dorosłych lub generowania fałszywych filmów. Tymczasem internauci pomogli ulepszyć technologię, aby coraz trudniej było odróżnić prawdziwe filmy od fałszywych. W rezultacie sprawia to, że ten rodzaj sztucznej inteligencji jest bardzo potężny pod względem rozpowszechniania fałszywych wiadomości i mistyfikacji. Facebook Oferty Wskazówki, które pomogą Ci znaleźć fałszywe wiadomości Facebook Oferty porady pomogą Ci znaleźć fałszywe wiadomości Chociaż Facebook nie tworzy fałszywych wiadomości, to przynajmniej częściowo odpowiedzialny za jego rozpowszechnianie. Dlatego oferuje teraz wskazówki, które pomogą Ci znaleźć fałszywe wiadomości, zanim się rozpowszechnią. .

Aby pochwalić się potęgą technologii, reżyser Jordan Peele i dyrektor generalny BuzzFeed Jonah Peretti stworzyli fałszywe wideo pokazujące coś, co wydaje się być byłym prezydentem USA Barackiem Obamą przedstawiającym PSA na temat mocy głębokich płatków.

5. Powstanie botów Twittera

Boty na Twitterze zostały pierwotnie stworzone w celu zautomatyzowania takich rzeczy, jak odpowiedzi obsługi klienta dla marek. Ale technologia jest obecnie głównym powodem do niepokoju. W rzeczywistości badania wykazały, że nawet 48 milionów użytkowników Twittera to w rzeczywistości boty AI.

Zamiast po prostu używać algorytmów do śledzenia określonych hashtagów lub odpowiadania na zapytania klientów, wiele kont botów próbuje naśladować prawdziwych ludzi. Ci „ludzie” następnie promują mistyfikacje i pomagają w rozpowszechnianiu fałszywych wiadomości.

Fala botów na Twitterze wpłynęła nawet w pewnym stopniu na opinię publiczną na temat Brexitu i wyborów prezydenckich w USA w 2016 r. Sam Twitter przyznał, że odkrył około 50 000 rosyjskich botów, które pisały o wyborach.

Boty nadal nękają serwis, szerząc dezinformację. Problem jest tak duży, że wpływa nawet na wycenę spółki.

6. Pracownicy twierdzą, że Amazon AI zdecydował, że zatrudnienie mężczyzn jest lepsze

W październiku 2018 r.Reuters poinformował, że Amazon musiał zlikwidować narzędzie do rekrutacji po tym, jak AI oprogramowania zdecydowało, że kandydaci na mężczyzn są preferencyjni.

Pracownicy, którzy chcieli pozostać anonimowi, zgłosili się do Reutera, aby opowiedzieć o swojej pracy nad projektem. Deweloperzy chcieli, aby AI zidentyfikowała najlepszych kandydatów do pracy na podstawie ich CV. Jednak osoby zaangażowane w projekt wkrótce zauważyły, że AI ukarała kandydatki. Wyjaśnili, że AI używało CV z ostatniej dekady, z których większość pochodziła od mężczyzn, jako zbioru danych szkoleniowych.

W rezultacie AI zaczęło odfiltrowywać CV na podstawie słowa kluczowego “kobiety”. Słowa kluczowe pojawiły się w CV w ramach działań takich jak “kobiecy kapitan klubu szachowego”. Podczas gdy programiści zmienili AI, aby zapobiec karaniu CV kobiet, Amazon ostatecznie zlikwidował projekt.

7. Niewłaściwe treści w YouTube Kids

YouTube Kids ma wiele głupich, kapryśnych filmów, które mają zabawiać dzieci. Ale ma też problem ze spamowymi filmami, które manipulują algorytmem platformy.

Te filmy oparte są na popularnych tagach. Ponieważ małe dzieci nie są bardzo wymagającymi widzami, niepotrzebne filmy zawierające te słowa kluczowe przyciągają miliony wyświetleń. AI automatycznie generuje niektóre z tych filmów przy użyciu elementów animacji giełdowej, na podstawie tagów trendów. Nawet jeśli filmy są tworzone przez animatorów, ich tytuły są generowane specjalnie do upychania słów kluczowych.

Te słowa kluczowe pomagają manipulować algorytmem YouTube, aby uzyskać rekomendacje. Znaczna ilość nieodpowiednich treści pojawiła się w kanałach dzieci korzystających z aplikacji YouTube Kids. Obejmuje to treści przedstawiające przemoc, podskoki i treści seksualne.

Dlaczego uczenie maszynowe idzie źle?

Istnieją dwa główne powody, dla których uczenie maszynowe powoduje niezamierzone konsekwencje: dane i ludzie. Pod względem danych mantra “śmieci, śmieci” dotyczy. Jeśli dane podawane do AI są ograniczone, stronnicze lub niskiej jakości; wynikiem jest sztuczna inteligencja o ograniczonym zakresie lub uprzedzeniu.

Ale nawet jeśli programiści poprawnie uzyskają dane, ludzie mogą rzucić klucz do prac. Twórcy oprogramowania często nie zdają sobie sprawy, w jaki sposób ludzie mogą wykorzystywać tę technologię złośliwie lub w celach samolubnych. Deepfakes pochodziły z technologii stosowanej do poprawy efektów specjalnych w kinie.

To, co ma na celu zapewnić bardziej wciągającą rozrywkę, rujnuje życie ludzi, gdy zostanie wykorzystane.

Są ludzie pracujący nad poprawą zabezpieczeń technologii uczenia maszynowego, aby zapobiec złośliwemu użyciu. Ale technologia już tu jest. Tymczasem wiele firm nie wykazuje wymaganej siły woli, aby zapobiec nadużywaniu tych rozwiązań.

Algorytmy uczenia maszynowego mogą nam pomóc

Może wydawać się to tragiczne i przygnębiające, gdy uświadomisz sobie, jak wiele uczenia maszynowego i sztucznej inteligencji nie spełnia oczekiwań. Ale pomaga nam również na wiele sposobów - nie tylko pod względem wygody, ale ogólnie poprawia nasze życie.

.