Peter Holmes

0

4821

1361

Jeśli prowadzisz witrynę internetową 10 sposobów na stworzenie małej i prostej strony internetowej bez nadmiernej siły 10 sposobów na stworzenie małej i prostej strony internetowej bez nadmiernej siły WordPress może być przesadą. Jak dowodzą te inne doskonałe usługi, WordPress to nie wszystko i koniec tworzenia stron internetowych. Jeśli chcesz prostszych rozwiązań, możesz wybierać spośród wielu. , prawdopodobnie słyszałeś o pliku robots.txt (lub “standard wykluczania robotów”). Niezależnie od tego, czy masz, czy nie, czas się o tym dowiedzieć, ponieważ ten prosty plik tekstowy jest kluczową częścią witryny. To może wydawać się nieistotne, ale możesz być zaskoczony, jak ważne jest to.

Rzućmy okiem na to, czym jest plik robots.txt, co robi i jak poprawnie skonfigurować go dla Twojej witryny.

Co to jest plik robots.txt?

Aby zrozumieć, jak działa plik robots.txt, musisz dowiedzieć się trochę o wyszukiwarkach Jak działają wyszukiwarki? Jak działają wyszukiwarki? Dla wielu osób Google jest internetem. Jest to prawdopodobnie najważniejszy wynalazek od samego Internetu. Chociaż od tego czasu wyszukiwarki wiele się zmieniły, podstawowe zasady są nadal takie same. . Krótka wersja jest taka, że wysyłają “roboty,” które są programami, które przeszukują Internet w poszukiwaniu informacji. Następnie przechowują niektóre z tych informacji, aby później móc skierować do nich ludzi.

Te roboty, znane również jako “boty” lub “pająki,” znaleźć strony z miliardów stron internetowych. Wyszukiwarki podają wskazówki, dokąd pójść, ale poszczególne witryny mogą również komunikować się z botami i wskazywać, które strony powinny przeglądać.

W większości przypadków robią coś przeciwnego i mówią im, które strony nie powinien patrzeć na. Rzeczy takie jak strony administracyjne, portale zaplecza, strony kategorii i tagów oraz inne rzeczy, których właściciele witryn nie chcą wyświetlać w wyszukiwarkach. Te strony są nadal widoczne dla użytkowników i są dostępne dla każdego, kto ma pozwolenie (często każdy).

Ale mówiąc tym pająkom, aby nie indeksowały niektórych stron, plik robots.txt robi wszystkim przysługę. Jeśli szukałeś “Zrobić użytek z” w wyszukiwarce, czy chciałbyś, aby nasze strony administracyjne pokazywały się wysoko w rankingach? Nie, to by nikomu nic nie pomogło, dlatego mówimy wyszukiwarkom, aby ich nie wyświetlały. Można go również użyć do powstrzymania wyszukiwarek przed sprawdzaniem stron, które mogą nie pomóc im sklasyfikować witryny w wynikach wyszukiwania.

Krótko mówiąc, robots.txt mówi robotom internetowym, co ma robić.

Czy roboty mogą zignorować plik robots.txt?

Czy roboty indeksujące kiedykolwiek ignorują pliki robots.txt? Tak. W rzeczywistości wiele robotów zrobić zignoruj to. Zasadniczo jednak roboty te nie pochodzą z renomowanych wyszukiwarek. Pochodzą od spamerów, osób zbierających wiadomości e-mail i innych rodzajów automatycznych botów, które wędrują po Internecie. Ważne jest, aby o tym pamiętać - użycie standardu wykluczania robotów w celu nakazania botom trzymania się z daleka nie jest skutecznym środkiem bezpieczeństwa. W rzeczywistości niektóre boty mogą początek ze stronami, które każesz im nie wchodzić.

Wyszukiwarki działają jednak tak, jak mówi plik robots.txt, o ile jest poprawnie sformatowany.

Jak napisać plik robots.txt

Istnieje kilka różnych części, które znajdują się w standardowym pliku wykluczenia robota. Rozłożę je tutaj osobno.

Deklaracja agenta użytkownika

Zanim powiesz botowi, na których stronach nie powinien patrzeć, musisz określić, z którym botem rozmawiasz. Przez większość czasu będziesz używać prostej deklaracji, co oznacza “wszystkie boty.” To wygląda tak:

Agent użytkownika: *Gwiazdka oznacza “wszystkie boty.” Możesz jednak określić strony dla niektórych botów. Aby to zrobić, musisz znać nazwę bota, dla którego wyznaczasz wytyczne. Może to wyglądać tak:

User-agent: Googlebot [lista stron, których nie można indeksować] User-agent: Googlebot-Image / 1.0 [lista stron, których nie można indeksować] User-agent: Bingbot [lista stron, których nie można indeksować]I tak dalej. Jeśli odkryjesz bota, którego w ogóle nie chcesz indeksować, możesz to również określić.

Aby znaleźć nazwy agentów użytkownika, sprawdź useragentstring.com [Nie jest już dostępny].

Niedozwolone strony

To jest główna część pliku wykluczenia robota. Za pomocą prostej deklaracji informujesz bota lub grupę botów, aby nie indeksowały niektórych stron. Składnia jest łatwa. Oto, jak możesz zabronić dostępu do wszystkiego w “Administrator” katalog Twojej witryny:

Disallow: / admin /Wiersz ten powstrzyma boty przed indeksowaniem twoich witryn.com/admin, twoich witryn.com/admin/login, twoich witryn.com/admin/files/secret.html i wszystkiego innego, co znajduje się w katalogu administratora.

Aby zabronić pojedynczej strony, po prostu określ ją w wierszu zabronienia:

Disallow: /public/exception.htmlTeraz “wyjątek” strona nie zostanie narysowana, ale wszystko inne w “publiczny” folder będzie.

Aby dołączyć wiele katalogów lub stron, po prostu wypisz je w kolejnych wierszach:

Disallow: / private / Disallow: / admin / Disallow: / cgi-bin / Disallow: / temp /Te cztery wiersze będą miały zastosowanie do dowolnego agenta użytkownika określonego w górnej części sekcji.

Jeśli chcesz uniemożliwić botom przeglądanie dowolnej strony w witrynie, skorzystaj z tego:

Disallow: /Ustanawianie różnych standardów dla botów

Jak widzieliśmy powyżej, możesz określić określone strony dla różnych botów. Łącząc poprzednie dwa elementy, oto jak to wygląda:

User-agent: googlebot Disallow: / admin / Disallow: / private / User-agent: bingbot Disallow: / admin / Disallow: / private / Disallow: / secret /The “Administrator” i “prywatny” sekcje będą niewidoczne w Google i Bing, ale Google zobaczy “sekret” katalog, podczas gdy Bing nie.

Możesz określić ogólne zasady dla wszystkich botów za pomocą agenta użytkownika w gwiazdce, a następnie podać szczegółowe instrukcje botom w kolejnych sekcjach.

Kładąc wszystko razem

Mając powyższą wiedzę, możesz napisać pełny plik robots.txt. Po prostu uruchom swój ulubiony edytor tekstu (jesteśmy fanami Sublime 11 Sublime Text Wskazówki dotyczące produktywności i szybszego przepływu pracy 11 Sublime Text Wskazówki dotyczące produktywności i szybszego przepływu pracy Sublime Text to wszechstronny edytor tekstu i złoty standard dla wielu programistów. porady skupiają się na wydajnym kodowaniu, ale użytkownicy z pewnością docenią skróty klawiaturowe. tutaj) i zacznij informować boty, że nie są mile widziane w niektórych częściach Twojej witryny.

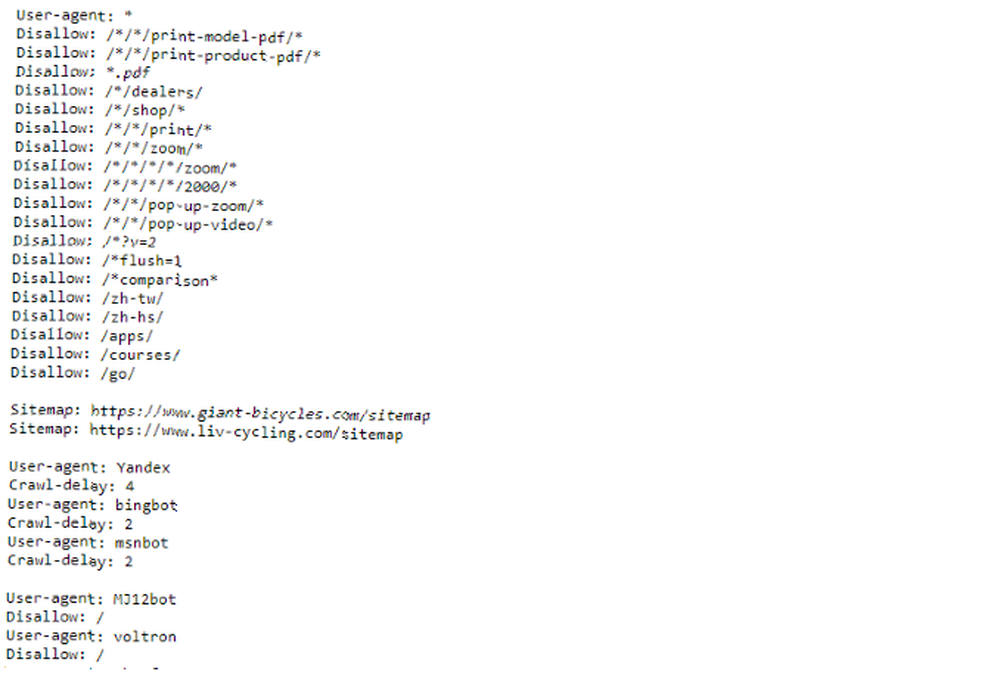

Jeśli chcesz zobaczyć przykład pliku robots.txt, po prostu przejdź do dowolnej witryny i dodaj “/robots.txt” do końca. Oto część pliku robots.txt Giant Bicycles:

Jak widać, istnieje sporo stron, których nie chcą wyświetlać w wyszukiwarkach. Zawarli także kilka rzeczy, o których jeszcze nie rozmawialiśmy. Przyjrzyjmy się, co jeszcze możesz zrobić w pliku wykluczenia robota.

Lokalizowanie mapy witryny

Jeśli plik robots.txt informuje boty, gdzie nie aby przejść, mapa witryny robi odwrotnie. Jak utworzyć mapę witryny XML w 4 prostych krokach Jak utworzyć mapę witryny XML w 4 prostych krokach Istnieją dwa rodzaje map witryn - strona HTML lub plik XML. Mapa witryny HTML to pojedyncza strona, która pokazuje odwiedzającym wszystkie strony w witrynie i zwykle zawiera linki do tych… i pomaga im znaleźć to, czego szukają. I chociaż wyszukiwarki prawdopodobnie już wiedzą, gdzie jest mapa witryny, nie jest bolesne, aby dać im znać.

Deklaracja lokalizacji mapy witryny jest prosta:

Mapa witryny: [URL mapy witryny]To jest to.

W naszym własnym pliku robots.txt wygląda to tak:

Mapa strony: //www.makeuseof.com/sitemap_index.xmlTo wszystko.

Ustawianie opóźnienia indeksowania

Dyrektywa o opóźnieniu indeksowania informuje niektóre wyszukiwarki, jak często mogą indeksować stronę w Twojej witrynie. Mierzy się go w sekundach, choć niektóre wyszukiwarki interpretują to nieco inaczej. Niektórzy widzą opóźnienie indeksowania wynoszące 5, które każe im czekać pięć sekund po każdym indeksowaniu, aby zainicjować następne. Inni interpretują to jako instrukcję przeszukiwania tylko jednej strony co pięć sekund.

Dlaczego miałbyś mówić robotowi, aby nie czołgał się tak często, jak to możliwe? Aby zachować przepustowość 4 sposoby Windows 10 marnuje przepustowość Internetu 4 sposoby Windows 10 marnuje przepustowość Internetu Czy Windows 10 marnuje przepustowość Internetu? Oto jak to sprawdzić i co możesz zrobić, aby to zatrzymać. . Jeśli Twój serwer stara się nadążyć za ruchem, możesz wprowadzić opóźnienie indeksowania. Ogólnie rzecz biorąc, większość ludzi nie musi się tym martwić. Duże witryny o dużym natężeniu ruchu mogą jednak chcieć poeksperymentować.

Oto jak ustawić opóźnienie indeksowania na osiem sekund:

Opóźnienie pełzania: 8to jest to! Nie wszystkie wyszukiwarki będą przestrzegać Twojej dyrektywy. Ale nie zaszkodzi zapytać. Podobnie jak w przypadku niedozwolonych stron, możesz ustawić różne opóźnienia indeksowania dla określonych wyszukiwarek.

Przesyłanie pliku robots.txt

Po skonfigurowaniu wszystkich instrukcji w pliku możesz przesłać go do swojej witryny. Upewnij się, że jest to zwykły plik tekstowy i ma nazwę robots.txt. Następnie prześlij go do swojej witryny, aby można go było znaleźć na stronie twoja.com/robots.txt.

Jeśli korzystasz z systemu zarządzania treścią 10 najpopularniejszych systemów zarządzania treścią online 10 najpopularniejszych systemów zarządzania treścią online Dni ręcznego kodowania stron HTML i opanowania CSS już dawno minęły. Zainstaluj system zarządzania treścią (CMS), aw ciągu kilku minut możesz założyć stronę internetową, z której możesz dzielić się ze światem. podobnie jak WordPress, prawdopodobnie istnieje konkretny sposób, w jaki musisz to zrobić. Ponieważ różni się w zależności od systemu zarządzania treścią, należy zapoznać się z dokumentacją systemu.

Niektóre systemy mogą mieć również interfejsy online do przesyłania plików. W tym celu wystarczy skopiować i wkleić plik utworzony w poprzednich krokach.

Pamiętaj, aby zaktualizować plik

Ostatnią radą, jaką dam, jest od czasu do czasu przejrzenie pliku wykluczenia robota. Twoja witryna zmienia się i może być konieczne wprowadzenie pewnych poprawek. Jeśli zauważysz dziwną zmianę w ruchu w wyszukiwarce, dobrym pomysłem jest również sprawdzenie pliku. Możliwe jest również, że standardowa notacja może ulec zmianie w przyszłości. Podobnie jak wszystko inne w Twojej witrynie, warto od czasu do czasu to sprawdzić.

Z których stron wykluczasz roboty w swojej witrynie? Czy zauważyłeś jakąś różnicę w ruchu w wyszukiwarkach? Podziel się swoimi poradami i komentarzami poniżej!